Java中爬虫怎么实现 分析网页抓取技术

java中实现爬虫的核心在于模拟浏览器行为并提取信息,主要依赖网络请求库(如httpclient、okhttp)、html解析库(如jsoup)及多线程技术。1. 网络请求推荐使用httpclient或okhttp,二者功能强大且性能优秀;2. html解析常用jsoup,其支持css选择器且简单易用;3. 动态页面需借助htmlunit或selenium获取渲染后的内容;4. 反爬虫应对策略包括设置user-agent、使用代理ip、处理cookie等;5. 性能优化可通过连接池、gzip压缩、缓存、多线程等方式实现;6. 其他html解析库如htmlunit适合动态网页,jericho和nekohtml各有优劣,应根据需求选择。

Java中实现爬虫,核心在于模拟浏览器行为,抓取网页内容,并从中提取所需信息。这涉及到网络请求、HTML解析、数据提取等环节。

解决方案

Java实现爬虫主要依赖以下几个关键技术和库:

立即学习“Java免费学习笔记(深入)”;

-

网络请求:

- java.net.URL 和 java.net.URLConnection: 这是Java自带的基础网络请求类,可以用来发送GET和POST请求,获取网页的HTML内容。但使用起来比较繁琐,需要手动处理Cookie、Header等。

- HttpClient (Apache HttpClient): 更强大、更灵活的HTTP客户端,可以处理复杂的网络请求,支持各种HTTP方法、代理、Cookie管理等。

- OkHttp: Square公司开发的HTTP客户端,性能优秀,API简洁易用,支持HTTP/2和WebSocket。

推荐使用HttpClient或OkHttp,它们提供了更丰富的功能和更好的性能。

// OkHttp示例 OkHttpClient client = new OkHttpClient(); Request request = new Request.Builder() .url("https://www.example.com") .build(); try (Response response = client.newCall(request).execute()) { if (!response.isSuccessful()) throw new IOException("Unexpected code " + response); String html = response.body().string(); System.out.println(html); // 打印网页HTML内容 } catch (IOException e) { e.printStackTrace(); }登录后复制文章作者:磁力搜索

文章标题:Java中爬虫怎么实现 分析网页抓取技术

文章链接:https://www.onehaoka.com/4133.html

本站所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议,转载请注明来自磁力搜索 !

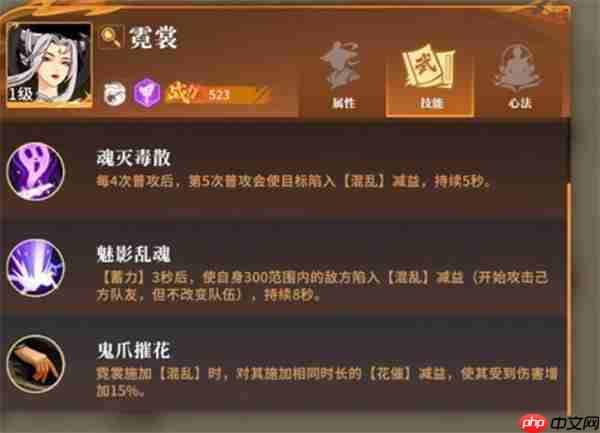

对决剑之川开荒天花板:零失误英雄投资手册

进入《剑锋逐梦录》的世界,初学者的每一个选择都会影响整个发展路径!选错了角色?这将导致资源浪费并使进程陷入困境。别在起点迷失自我,这篇细致入微的版本攻略将帮你

2025年06月16日

Java中如何实现热部署 掌握类重新加载

java热部署是指在不重启jvm的情况下更新线上代码,其核心通过自定义类加载器实现类的动态加载与替换。1. 自定义类加载器是基础,每次代码更新后创建新类加载器

2025年06月16日

豆包AI的「爆款标题生成器」如何提升点击率?10个案例对比

豆包ai的「爆款标题生成器」能提升点击率,但效果取决于使用方式。首先明确主题和受众,输入具体关键词;其次不直接采用生成标题,应优化使其更贴合内容;再次增强吸引

2025年06月16日

地狱潜兵2战备指令一览

今天给大家带来的是《地球防卫军2:全球剿灭》中战备指令的全面总结。在游戏中,战备指令是扭转战局的关键工具,合理使用这些指令能够大幅提升作战效率。 关于《地球防

2025年06月16日

封神开天张奎深度解析:追击骑阵容构建与实战技巧

李奎,这位《封神:创世》战局里的锋利尖刀,凭借精准的定位成为乙木体系中不可或缺的关键拼图。他的价值,远超“工具人”的简单定义,而是象征着稳定高效的木系能量推动

2025年06月16日

学mysql能从事什么工作 数据库相关岗位需求分析

学mysql能从事的工作包括数据库管理员(dba)、数据分析师、后端开发工程师和数据工程师。1)dba负责数据库维护、性能调优和安全管理;2)数据分析师利用m

2025年06月16日

html中如何设置列表样式?列表美化方法详解

在html中设置列表样式主要通过css实现,具体步骤包括:1.去除默认样式以统一基础风格;2.使用list-style调整项目符号类型、位置及图片;3.通过伪

2025年06月16日

英雄联盟手游基兰正式服上线倒计时:时光守护者全机制前瞻

当你的adc在团战中又一次不幸阵亡,发出“如果可以重来”的感慨时,峡谷中的时光掌控者已经悄然按下了加速按钮!大家期待已久的基兰,终于以时光守护者的身份降临手游

2025年06月16日

最新评论